上海水冷板数据中心液冷电话

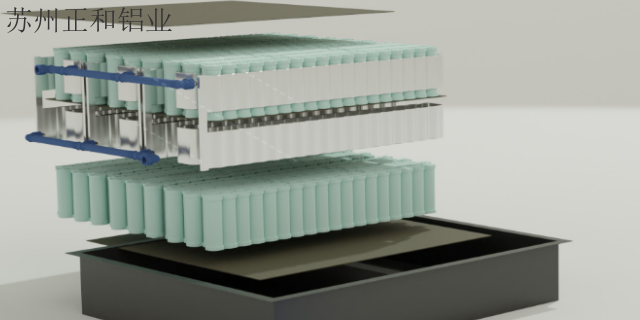

液冷在高性能数据中心的使用是相关技术第二大应用领域。国内三大运营商中国移动、中国电信和中国联通2023年6月发布的《电信运营商液冷技术白皮书》中指出,2023年运营商开展液冷技术验证,2024年开展规模测试,10%新建项目规模试点液冷技术,2025年50%以上新建数据中心项目应用液冷技术,电信行业力争成为液冷技术的带领者、产业链的领航者、推广应用的带领者。目前液冷技术分为直接液体冷却和间接液体冷却,其中间接液体冷却以冷板式为主,直接液体冷却以浸没式和喷淋式为主,按照技术难度从低到高排序为冷板式液冷、浸没式液冷和喷淋式液冷技术。性价比高的数据中心液冷的公司。上海水冷板数据中心液冷电话

GPU使用日益增加:GPU由数百个内核组成,可同时处理数千个线程,相应地功耗更高。(3)低延迟需求导致热密度增加:随着服务器组件性能的提高,不同组件之间的互连在延迟方面开始成为瓶颈。为了充分利用提升的组件性能,CPU、GPU和板卡上的其他组件被更加紧密的安排以减少延迟,这同样提升了服务器内部的物理密度和温度越来越高。同时根据ODCC《冷板式液冷服务器可靠性白皮书》相关信息,在摩尔定律变缓的大背景下,芯片算力与其功耗同步出现了大幅提升。2022年Intel第四代服务器处理器单CPU功耗已突破350瓦,英伟达单GPU芯片功耗突破700瓦。持续进步的IT技术和算力能耗功率使得数据中心承载能力要求被不断提升。因此提升单机柜功率密度成为了调和不断增长的算力需求和有限的数据中心承载能力的关键解决方案。根据数据,2020年全球数据中心单机柜平均功率将达16.5kW,相比2008年提升175%,并且到2025年单柜功率有望进一步提升至25kW。湖南创新数据中心液冷电话正和铝业是一家专业提供数据中心液冷的公司,欢迎您的来电!

单相浸没式液冷中冷却液不会发生相变。单相浸没在浸没式单相液冷中,发热部件直接浸没在冷却液中进行热交换,循环泵将吸收了热量的冷却液导入热交换单元,在热交换单元中冷却后再循环回到箱体中为发热部件散热,冷却液在循环散热过程中始终保持液相。由于要确保冷却液不发生气化,单相浸没技术通常需要使用高沸点的冷却液,例如氟化学物质(或氟碳化合物)、烃类(例如矿物油、合成油和天然油)以及碳氢化合物。冷却液挥发流失控制相对简单,与IT设备有较好的电气兼容性,且不需要频繁补充,还易于卸载或更换服务器组件,提高了系统的可维护性。

2020年3月,常务委员会提出了加快数据中心等新型基础设施建设的要求。新基建是指以新发展理念为指引,以技术创新为驱动,以数据为主,以信息网络为基础,面向高质量发展需要,提供数字转型、智能升级、融合创新等服务的基础设施体系。数据中心作为基于新一代信息技术演化生成的基础设施,是算力基础设施的典型,数据中心发展迎来风口。但数据中心作为新型基础设施中的基础,其建设一直被能耗过大等环境议题所困扰,秉持绿色化发展原则已经成为了全社会的共识。提升数据中心能效,降低PUE已经成为数据中心发展的必然趋势。正和铝业为您提供数据中心液冷,有需求可以来电咨询!

浸没式液冷技术主要分为单相浸没式液冷和两相浸没式液冷。单相浸没式液冷和两相浸没式液冷数据中心构造的共同点是服务器电子部件浸没在电介质液体中,区别是单相浸没式使用循环泵将经过加热的电子氟化液流到热交换器,在热交换器中冷却并循环回到容器中;两相浸没式是在容器内实现热量交换,电子部件的热量传递到液体后引起沸腾并产生蒸汽,蒸汽在冷凝器上冷凝后热量在数据中心循环设施进一步冷却。两相浸没式冷却(2PLC)是数据中心冷却技术的新型发展方向,在数据处理量以及响应的热能大幅提升的背景下,它专为更高的沸点设计,可以防止流体变质并且不需要低温液体泵。通过电子氟化液(冷却液)的沸腾及冷凝过程,可以指数级地提高液体的传热效率。数据中心液冷的参考价格大概是多少?安徽防水数据中心液冷多少钱

数据中心液冷的性价比、质量哪家比较好?上海水冷板数据中心液冷电话

随着人工智能、云计算、大数据以及区块链等技术的创新发展,使得数据资源的存储、计算和应用需求快速扩张,特别是ChatGPT技术推广进一步催生了AI算力等大功率应用场景加速落地。作为信息基础设施的数据中心及通信设备承担的计算量越来越大,对计算效率的要求也越来越高,国内包括全球的数据中心建设有望迎来建设高峰。为了应对网络处理性能的挑战,数据中心服务器及通信设备不断提升自身处理能力和集成度,带来了功率密度的节节攀升。这些变化除了带来巨额能耗问题以外,高热密度也给制冷设备和技术提出了更高要求。传统风冷技术面对高热密度场景呈现瓶颈,散热效率已经跟不上计算效率。在此背景下,液冷技术以其超高能效、超高热密度等特点引起行业的普遍关注,是解决散热压力和节能挑战的必由之路。上海水冷板数据中心液冷电话

上一篇: 湖南防水数据中心液冷定制

下一篇: 个性化逆变器换热推荐货源